公众号/小象

源 | singularityhub 译 | 朱敏

《西部世界》是近几年来我最喜欢的电视剧之一。这部HBO电视剧集合了一流的演员,展现了未来人工智能最受争议的某些方面。我们发现,几乎在西部世界第一季的每一个情节中,人类都试图去理解在特殊情况下机器人所做的决定。每一次,人们都可以通过查询系统来获取机器人行为背后的解释。只需要简单的说“分析,解释X或Y”,机器人就会友好的详细描述它行为背后的复杂过程。如果在真实的AI系统中也是这样就好了。

在现代深度学习系统中,解释和说明认知是最难的问题之一。在监督深度学习系统中,模型训练的过程及其内置的知识,基本上是无法解释的。然而,解释认知是人类学习方式的一个关键元素。让我们来看看一个经典的学生-老师设置场景,该场景中老师正试图使用一系列的例子来向学生传达一个特定概念。老师会基于学生的反馈来调整解释,并选择最合适的例子来加深学生的认知。这种教学策略对人类很有效,但是对神经网络却非常不幸的失败了。

深度学习系统中一些最有趣的场景需要人类和神经网络的无缝协作。然而,在大部分场景中,双方交流方式的差异导致这种协作的建立极其艰难。OpenAI近期的一篇研究报告提出了一种更具教育学意义的方法来教导深度学习系统,试图挑战这一难题。

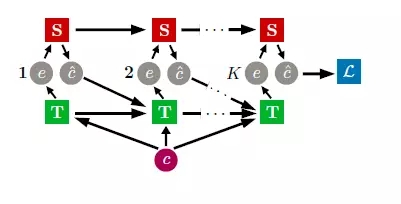

在“可解释和教育学的实例”的课题下,OpenAI研究者们提出了一个复杂的、关于是什么导致了理解深度学习系统如此困难的论点。在他们的观点中,部分挑战来自于大部分深度学习架构所依赖的老师和学生的神经网络是同时训练的,从而阻止了两者间的反馈回路。OpenAI团队制定了能迭代训练的老师和学生网络的模型,从而能够生成更可解释的教学策略。

可解释的机器学习

OpenAI提出的可解释的教学策略可被视为两个神经网络间的进化博弈:一个学生和一个老师。这场博弈针对学生的目标是让学生基于特定概念的例子来猜测这个概念,而老师的目标是为学生选择最有说明性的例子。用一个图像识别的场景作为类比,学生应该尽力去猜测图片中的概念,老师应该尽力去选择最合适的图片来加深学生的理解。

这个分两步走来解释教学的技术工作过程如下:一个“学生”神经网络随机选择概念的例子作为输入,使用传统的监督学习方法去猜测正确的概念标签。在第二阶段,“老师”网络,拥有已准备好的待教概念及链接概念和例子的标签,在学生网络上测试不同的例子,并观察学生所给出的概念标签,最终收敛到让学生猜出正确概念所需要的最小例子集。

OpenAI方法的关键点在于,老师和学生网络是迭代训练的,而非同时训练。而在传统的模式中,两个神经网络是被同时训练去选择人类难以理解的例子。OpenAI技术的目标是生成更可解释的教学策略,但是我们如何量化可解释?为了评测该模式的性能,OpenAI团队采用了两个基本的度量标准:

1. 评测每个任务中所选择的策略同凭直觉获知的策略的相似性。

2. 评测所选择策略在教育人类上的效果。

OpenAI的研究者们已将可解释策略应用在了各种各样的场景中,获得了显著的成效,极大地改进了传统技术。更具体的说,可解释的教学方法让学生模型学到了一个可解释的学习策略,同时也约束了老师模型去学习一个可解释的教学策略。

找了好久才找到这里,来了就不想走!