在20世纪50年代和60年代人工智能研究的早期阶段,我们的目标是创造出能够模拟人类思考和行为方式的计算机,重塑我们对周围世界的直观理解能力。但事实证明,对于20世纪50年代的计算机程序来说,思考这一行为要复杂得多。研究结果是令人失望的。

不过,最终人们放弃了让计算机思考,转而专注于令它完成非常具体的任务,并向它们提供了大量的相关数据,这导致了我们今天看到的人工智能热潮。计算机可以在国际象棋中击败人类,然而它们不是通过优雅地下一步棋来获得满足感,而是在此前的数百万场比赛中筛选,看哪一步棋更有可能帮助获得胜利。

不过,在2017年,人工智能可能需要解决一个老生常谈的问题:教会计算机如何变得更人性化。人工智能先驱人物Geoffrey Hinton最近对Axios说,他对一些方法“深表怀疑”,比如使用一堆象棋比赛数据来教会它们下象棋。相反,计算机应该能够不依靠数百万个特定的数据点来自主学习,就像人类一样。

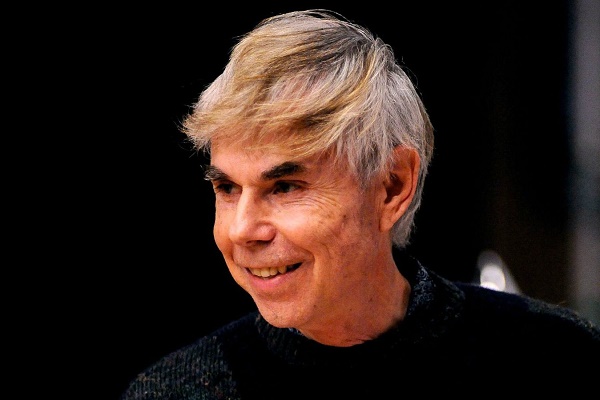

在人工智能的所有这些变化中,印第安纳大学的认知科学和比较文学教授Hofstadter,则一直在试图理解思维是如何运作的。他不相信我们现在拥有的人工智能是真正“智能”的,他担心这个领域已经把人类带到了危险的道路上。外媒与Hofstadter先生(以下简称DH)就人工智能的现状、其中出现的错误、以及未来的危险等进行了讨论。

我并不是要侮辱谷歌翻译。我想说的是,你要记住,电脑所使用的词语并没有赋予它意义。

这件事发生在我身上,所以它是一个真实的情况。当时我从印第安纳州的布卢明顿市开车到芝加哥来做演讲。一两个小时后,我在高速公路上遇到了一场非常严重的交通堵塞。

我离芝加哥还很远,而高速公路已经完全走不动了。那么我要做什么决定呢?我看到有些人正试图驾车穿过南北交通路段之间的草地,我以为他们会在高速公路上往南走,然后可能下车,走一些更小的路。这是有可能的,但后来我发现有些车被困在了泥泞的草地上。所以我就想:“我要去冒这个险吗?”

假设我在那等了一段时间,最后又回到了高速公路上。但当时我压力真的很大,要赶去芝加哥。我已经浪费了一个小时,几乎没有时间了。现在我该怎么办?我要承担多大的风险?对我来说,去这所大学发表这堂课对我来说有多重要?如果我打电话说我要迟到半个小时会怎么样?晚了一个小时?所以我开车时思考着,我要不要在限速70英里每小时的区域开到80迈?或者90?我要开多快?

对我来说,这些思考是“驾驶”的一部分。这才是开车。它表明,现实世界的因素在许多方面可以影响到驾驶。

真实世界并不像象棋或围棋那样有一个方方正正的框。有些情景是毫无边界的,你不知道这个状况下会发生什么,也不知道此状况外又会发生什么。

当我刚接触这个领域的时候,我有这样的感觉:创造出那些看起来似乎会思考的程序是很有趣的,即使它们只会做一些非常有限的思考,却给你一种接近自然人思维的错觉,这一点很有意思。越微妙,就越好。

但到最近,随着AlphaGo和DeepBlue的各种胜利,人们开始怀疑这两条线是否会出现交叉。人们认为它们在接近,然后相交,并没有渐近线。它相交了,然后计算机那条线继续上升。这和我的想法不同,我不太喜欢这个结果。

人类的思维被淹没在尘埃中这一点令我害怕。不是被计算机辅助或教唆,而是被完全压倒,人类在计算机面前就像是曾经出现在我们面前的蟑螂或跳蚤弱小不堪,如果真到了那一天,那就太可怕了。

编译 | 网易见外智能编译平台

审校 | 小ka